a16zブログ翻訳ができるまで

私が翻訳から離れてほぼ2年が過ぎようとしている。2021年5月にMPowe Partners Fundを立ち上げたあとにも私が翻訳した書籍は何冊か出版されているが、立ち上げた後に翻訳に取り掛かった書籍は1冊だけで、それ以外はいずれもかなり以前に依頼されファンドの立ち上げ前から翻訳を進めていた書籍だった。

ベン・ホロウィッツさんの著作『What you do is who you are』を浅枝大志さんと一緒に翻訳したのは2019年から2020年にかけてで、ちょうどMPowerの立ち上げを考えていた頃だった。その後、さまざまな縁と偶然が重なってホロウィッツさんにはじめてお会いしたのは、ファンドを立ち上げてからほぼ一年が経った2022年春のことだ。何波目かのコロナで外国からの入国は制限されていた時期だった。

ホロウィッツさんは2022年を通して何度か来日され、2023年の年初にはラスベガスで西村大臣とも面会している。『What you do is who you are』を読めばわかる通り、ホロウィッツさんは大の日本通である。日本のスタートアップ界のために自分ができることはないか、と以前から考えて下さっていたようだ。

折しも日本では、「新しい資本主義」の目玉としてスタートアップ支援策が打ち出されている。今回、政府主導でa16zのパートナーとポートフォリオ会社が来日しカンファレンスを開けることになったのは、ホロウィッツさんの日本びいきと純粋な厚意のおかげだと思っている。

カンファレンスに先立って、a16zが取り上げたい話題を中心に、何本かのブログを日本語に翻訳してみようと提案したのは私たちである。日本にもa16zのブログ読者は多いはずだが、正式に日本語に翻訳されたものはない。ちょうどいい機会なので、思い切ってホロウィッツさんにお願いしてみた。かくして、数ある人気ブログ記事の中から、今回のカンファレンスのトピックに関連の深いブログ記事をa16zのメディアチームにいくつか選んでもらい、許可された数本を私が翻訳することになった。

気合いを入れて臨んだものの、翻訳は約2年ぶり。翻訳の筋肉はすっかり溶けて跡形もない。パラグラフをひとつ終えるだけで息があがる。しかも、まとまった時間がなかなか取れず、集中力は続かない。今回のトピックについてもまったくの門外漢だ。こんなはずじゃなかったと思ったが、あとの祭りである。

ところで、2019年の『What you do is who you are』の翻訳にあたっては、実験的な手法を試してみることになった。バイリンガルの浅枝さんが原文を目で追いながら同時通訳的に音声で日本語の話し言葉を録音し、それを文字起こししたものをもとに、私が文章を綴ることにした。その数年前にベンさんが来日した時に浅枝さんが通訳を務めていたことから、この方法を思いついたのだ。このやり方ならホロウィッツさんが語りかけているような文章になり、時間も短縮できるだろうと仮説を立てた。

当時はまだChatGPTは存在しなかった。また、機械翻訳と人力を組み合わせる方法は私には合わないと感じていた。機械の書いた文章を直すのは、私にとって苦行オブ苦行である。はなから自分で翻訳した方が楽だし、結局早く仕上がる。しかし巷の噂によると、どうやら生成AIの進化は凄まじいらしい。一方の私といえば、翻訳筋肉も集中力も失ってしまった。そろそろ生成AIにお任せする潮時かもしれないし、そうでないかもしれない。

翻訳の未来を考えると、いつか人力翻訳は手の届かない贅沢品になるか、高尚な趣味の領域に入るだろうと思っている。それは、自動運転がコモディティとなる未来で、人間による運転がスタントやF1レースなどの特殊技能だけに使われたり、あるいは人力運転を珍しい道楽として消費するイメージに近い。ただ、今の時点ではどうだろう? 英日翻訳に限られるが(言語によっては違うかもしれない)、生成AIは人力(プロ)と比べてどこまでの域に達しているのだろうか?

そんなわけで、今回はカンファレンスのトピックである生成AIに合わせて新しい実験を企てた。ひとつの素材(「Who Owns the Generative AI Platform?」)で、人力チームとAIチームを競わせてみることにしたのだ。人力チームはプロの翻訳者(関)が翻訳し、エンジニアとプロのライターの方にチェックをお願いした。こちらはテクノロジー要素ゼロの、200%昔ながらの人力翻訳である。そして、同じブログをChatGPTに翻訳させたあと翻訳経験のないインターン(学部生)にチェックしてもらったバージョンも準備した(生成AI+素人バージョン)。人力チームとChatGPTチームは隔離され、お互いの翻訳は見ていない。

生産性を比較するにはそれぞれのチームが時間を測るべきなのだが、人力チームは本業の間に隙間時間でちょこちょこと翻訳したりチェックをしたりしていたため、全部で何時間かかったのかを測り損ねてしまった。翻訳をはじめてからチェックが終わるまでにおよそ2週間はかかっている。一方、AIチームには実働時間をきちんと測ってもらった。翻訳とチェックにかかった時間は合わせて12時間22分である。本来ならコストも比較すべきなのだが、やっていない。AIチームの方が安いことは明らかだが、人力チームと比べてどのくらいの差になるかは計算していない。従って、今回は純粋な「翻訳品質」のみの比較になる。(時間とコストの正確な比較はいつかやってみたいと思っている。)

前置きがすっかり長くなってしまったが、ここからが読者の皆さんへのお願いだ。この1万字近いブログ記事の翻訳を2種類とも読んで下さる奇特な方がいらっしゃったなら、どちらの翻訳がよかったかを投票にて教えていただきたい。どちらがAIによるもので、どちらが私の翻訳かは明かさないでおく。私もChatGPTバージョンは読んでいない(投票が終わるまで、読まないでおこうと思う)。

だけど、翻訳の良し悪しなど忘れてブログの中身に没頭できたと読者に思っていただけることが、翻訳者にとってのなによりのご褒美であることは申し添えておきたい。(関美和)

※投票はX(Twitter)またはLinkedInよりお願いします

※10月11日に開催されるa16zと経済産業省主催のイベント「It’s Time to Build 2023」へのお申し込みはこちらから

だれが生成AI市場を制するか

(執筆:Matt Bornstein, Guido Appenzeller, Martin Casado)

生成AIの領域で、ごく初期段階の技術スタックが生まれている。無数のスタートアップがこの市場に押し寄せ、基礎モデルの開発、AIネイティブのアプリケーション開発、そして立ち上げに必要なインフラ/ツール提供を行っている。

世の中が熱狂するテクノロジーの多くは、いつも過度な期待が先行し、市場が追いつくのはずっとあとのことになる。だが生成AIのブームには現実の市場での目にみえる利益が伴い、現実の企業から本物のトラクション(引き合い)がある。Stable DiffusionやChatGPTのようなモデルはかつてないほど短期間で利用が拡大し、発表から1年もたたないうちに年間売上が1億ドルを超えるアプリケーションもいくつかある。タスクによっては生成AIが人間のパフォーマンスを何倍も上回るものもある。

これまでの初期データを見ただけでも、世の中をガラリと変えるような転換が起きつつあると言っていいだろう。そこで私たちがまだ知らないこと、そして何よりも一番知りたいことは、「この市場のどこに価値が蓄積するのか」という問いへの答えだ。

昨年1年をかけて、私たちは生成AIに直接関わる大企業の運用者やスタートアップの創業者数十人と面談してきた。この市場での今のところの一番の勝ち組はおそらくインフラストラクチャー事業者で、生成AI市場に流れ込む資金の大半がインフラ企業の懐(ふところ)に入っている。アプリケーション企業は急速に売上を伸ばしているものの、リテンションにも差別化にも利益確保にも苦労している。一方モデルプロバイダーは生成AI市場の存在そのものを背負っているものの、商業的な規模拡大には至っていない。

ということは、一番価値を生み出している企業群ーたとえば、生成AIモデルを学習し、新しいアプリケーションに応用する企業ーはまだ儲かっていないのだ。次に何が起きるかはさらに予想しにくい。だが鍵になるのは、この市場のどの部分に真の差別化が存在し、どこに優位性が確立できるのかを知ることである。この点が市場構造に大きく影響し(たとえば水平統合対垂直統合)、長期的な価値の源泉となる(たとえば利益率とリテンション)。今のところは、既存大手が持つこれまでの優位性以外には、市場のどこにも構造的な競争優位は確立されていないようだ。

私たちは生成AIをとんでもなく強気に見ているし、生成AIがソフトウェア産業にも、またそれ以外にも大きなインパクトをもたらすと信じている。生成AI業界の市場構造を描き出し、そのビジネスモデルに関わる大きな問いに答えるのが、このブログの目指すところだ。

生成AI市場(スタック)を俯瞰する:インフラストラクチャー、モデル、アプリケーション

生成AI市場がどのように形作られつつあるかを理解するためにはまず、その構造をきちんと把握するところからはじめないといけない。

今のところは以下のような感じだろうか。

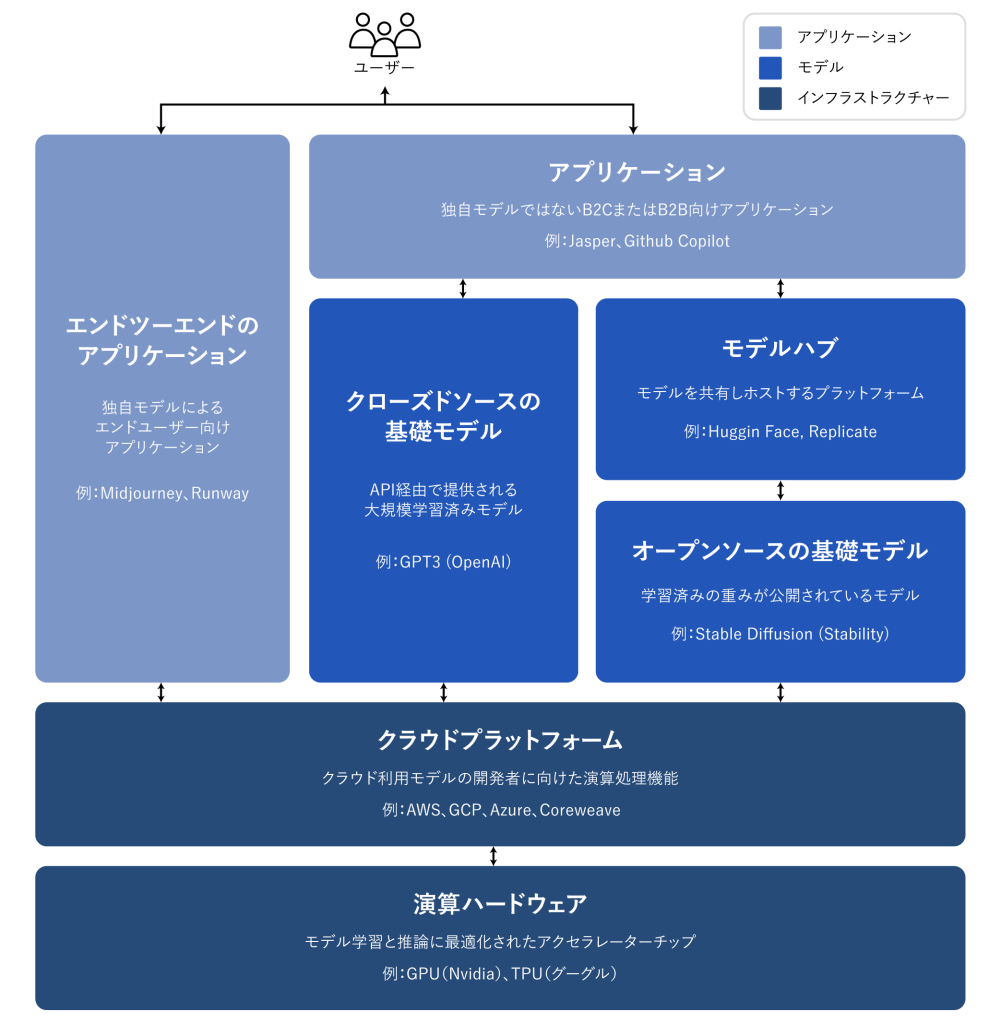

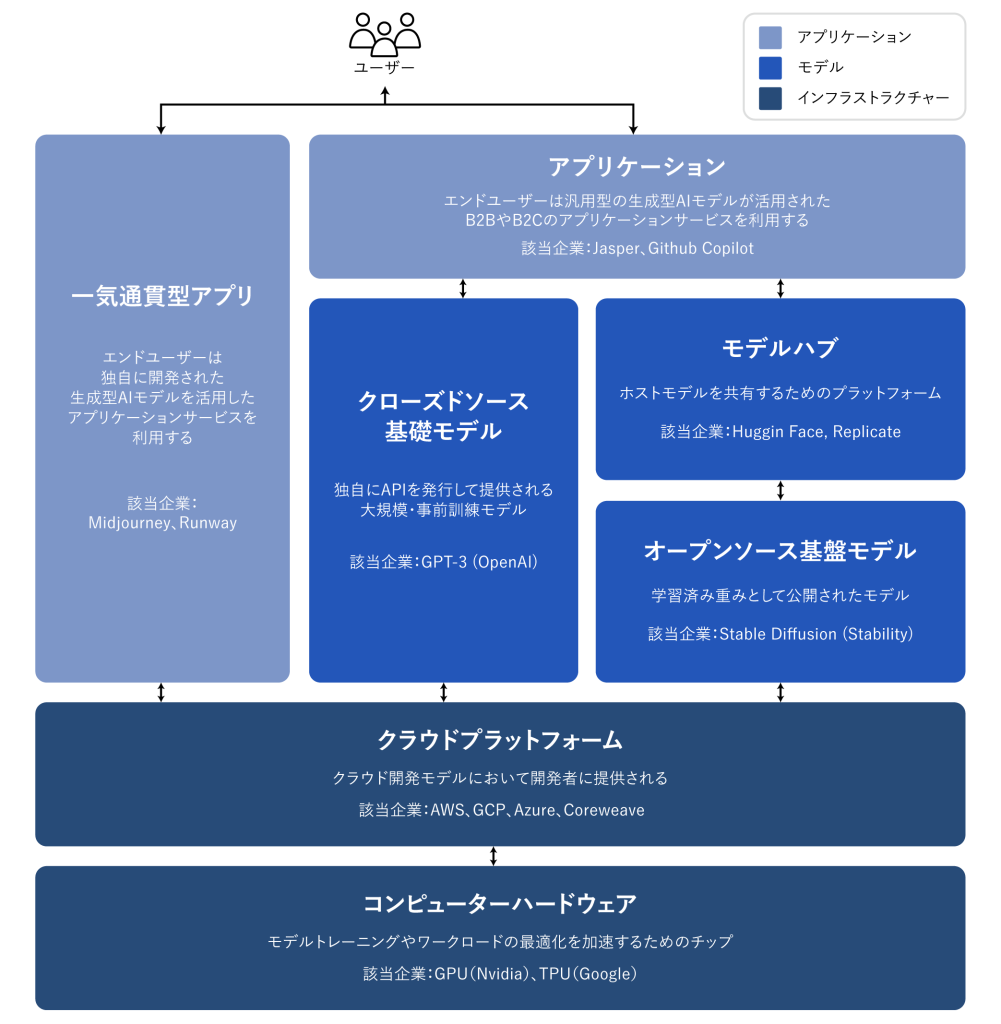

初期段階にある生成AIスタック

生成AIスタックは3層に分けられる。

アプリケーション:生成AIをユーザー向けプロダクトに組み入れる。独自モデルを走らせるもの(いわゆるエンドツーエンドのアプリケーション)もあれば、外部APIに依存するものもある

モデル:AIプロダクトを動かす。独自APIとして提供されるものもあれば、オープンソースのチェックポイントとして提供されるものもある(その場合にはホスティングのソリューションが必要になる)

インフラストラクチャー(クラウドプラットフォーム、ハードウェア製造企業など):生成AIに学習と推論を行わせる

ひとつ念を押しておくが、これは市場のカオスマップではない。生成AI市場を分析するためのフレームワークだと思ってほしい。ここではそれぞれのカテゴリーでよく知られた企業の例をいくつか挙げている。包括的なリストを作るつもりはないし、これまでにリリースされた非常に優れたアプリケーションをすべて網羅するつもりもない。またMlopsやLLMopsについても深掘りしない。それらのツールについては標準化が進んでいないので、またの機会に書くことにしよう。

生成AIアプリケーションの第1群はそろそろスケールしつつあるが、リテンションと差別化はできていない

これまでのテクノロジーサイクルでは、ユーザーが個人であれ企業であれ、「エンドカスタマーを囲い込む」ことが大規模な独立企業を築くために必須だと当然のように言われていた。生成AIにおいても規模拡大がもっとも狙いやすいのは、エンドユーザー向けアプリケーションだと思われがちだ。だが、そんな過去の通説が当てはまるかどうかはまだ定かでない。

たしかに生成AIアプリケーションの拡大は目覚ましい。これまでにない新鮮味があるし、ユースケースもごまんとあるからだ。実際に、年率換算した売上が1億ドルを超える分野は私たちが見るところで少なくとも3つある。画像生成、文章作成、プログラム作成だ。

とはいえ、ソフトウェア企業の場合、規模拡大しているから長続きするとは限らない。欠かせないのは成長に利益が伴うことだ。つまり、ユーザーや顧客の導入後に利益が確保でき(粗利率が高く)、長期にわたって顧客をつなぎ留めることが必要になる。B2BであれB2Cであれ、技術的な差別化があまりない中では、アプリケーションの長期的な顧客価値はネットワーク効果を通して、またはデータ確保や複雑なワークフローの構築を通して生み出されることになる。

だが、生成AIではこのような前提が必ずしも正しいとは限らない。これまで私たちが見てきたアプリケーション企業の粗利率にはかなりの幅がある。粗利が9割と高い企業もちらほらとはあるものの、ほとんどは5割から6割程度だ。これは推論コストが高いからだ。トップ企業群の成長は著しいものの、今の顧客獲得戦略がスケーラブルかどうかはわからない。有料顧客の獲得効率はすでに下がりはじめているし、リテンションも下がっている。アプリケーションの多くはあまり差別化できていない。それはアプリケーションの背後にあるAIモデルがいずれも似たようなもので、ネットワーク効果もまだあまり実現されておらず、競合他社に真似のできないようなデータ/ワークフローもないからだ。

そんなわけで、持続可能なAIビジネスを築くための唯一の方向性、またはベストな方向性がエンドユーザー向けアプリケーション開発なのかどうかはわからない。言語モデルの競争がさらに進み、効率が向上すれば粗利も改善されるはずだ(この点については以下に記している)。ただのひやかし客が一巡すればリテンションも上がるだろう。そして垂直統合型のアプリケーションが差別化に優位だと考えるもっともな理由もある。だがそこに至るまでに証明すべき点は多い。

生成AIアプリケーション企業が抱えるこれからの課題は次のようなものだ。

・垂直統合(モデル+アプリケーション):AIモデルをサービスとして利用する場合、アプリケーション開発企業は少人数のチームで素早く反復改善が行えるし、テクノロジーが進化するにつれてモデルを入れ替えることもできる。とはいえ、逆の見方をするとモデルがプロダクトそのものであり、ゼロから学習させることによってはじめて優位性が確立されるとも言える。つまり、他社にないデータを何度も学習し続けることによってモート(競争優位)が築かれるわけだ。ただし、そうするにはかなりの資金が必要となり、開発チームも小回りが利かなくなることを覚悟しなければならない。

・アプリケーション対機能開発

生成AIのプロダクトにはありとあらゆる形がある。デスクトップアプリケーション、モバイルアプリケーション、フィグマ/フォトショップのプラグイン、クロームの拡張機能、ディスコードのボットだってある。UIはただのテキストボックス(入力フォーム)なので、ユーザーがすでに利用している何かに埋め込めばいいだけだ。独立企業になれるのはどこだろう? マイクロソフトやグーグルなどすでにAIを統合している既存大手に吸収されるのはどの企業だろう?

・バブルのサイクルを上手く乗り切る

今ある生成AIプロダクトにとってユーザー離脱は折り込み済みとすべきか、それともこれは市場の黎明期だけなのか。AIバブルが落ち着くにつれ、生成AIへの関心も薄れていくのだろうか。こうした問いは次のことを考える上で重要な意味を持つ。いつ資金調達のアクセルを踏むべきか。どれほど積極的に顧客獲得にお金をかけるべきか。どのユーザー層を優先すべきか。プロダクト・マーケット・フィットができたかどうかをいつ明言できるのか。

生成AIの生みの親であるモデルプロバイダーは、いずれも商業的な規模拡大に至っていない

グーグルやOpenAIやStabilityといった企業が優れた研究と技術開発を行っていなければ、今のいわゆる生成AIはこの世に存在していなかった。斬新なモデル構築と、ものすごい努力による学習パイプラインの拡大があったからこそ、私たちは大規模言語モデル(LLM)や画像生成モデルのこれまでにない力の恩恵に預かることができている。

ただし、利用は拡大し大きな話題にはなるものの、それが生み出す収入はまだ意外に少ない。Stable Diffusionは画像生成分野で爆発的にコミュニティを拡大させている。彼らを支えているのは、ユーザーインターフェースやホスティングサービスの存在とファインチューニング方法を含む生態系だ。だがその開発企業であるStabilityは、事業の核である重要なチェックポイントを無料で提供している。自然言語モデルの領域は、ChatGPTとGPT3.5(当ブログ執筆当時)を持つOpenAIの寡占状態にある。だがOpenAI上でキラーアプリケーションと言えるものはあまりなく、価格はすでに一度引き下げられている。

もちろんこれは一時的な現象かもしれない。Stabilityはまだ若い企業でマネタイズに力を入れてはいない。OpenAIはキラーアプリケーションが増えればNLP(自然言語処理)分野の売上の大部分を稼ぎ出す巨大企業になる可能性はある。マイクロソフトのさまざまなプロダクトへの組入れがスムーズに進めば、その可能性は一層高まるだろう。彼らのモデルの莫大な利用価値を考えれば、巨額の売上もそう遠くないかもしれない。

だがこれに逆行する力もある。オープンソースのモデルは誰にでもホストできる。彼らは大規模学習の費用(数百億ドルはくだらない)を負担する必要がない。一方でクローズドソースのモデルがこの先ずっと競争優位性を保てるかどうかはわからない。たとえば、Anthropic、Cohere、Character.aiなどが開発した大規模言語モデルは性能面でOpenAIに近づいているし、同じようなデータセットを学習し、モデルのアーキテクチャもそれほど変わらない。Stable Diffusionの例を見るかぎり、オープンソースのモデルが一定の性能レベルに達し、かつコミュニティーの支持を得ることができれば、そのほかのクローズドモデルが勝つのはおそらく難しいように思える。

モデルプロバイダーについて今のところはっきりとしてきたのは、ホスティングが商業化に結びついているらしいということだ。プロプライエタリAPI(たとえばOpenAI)向け需要の伸びは著しい。オープンソースモデル向けのホスティングサービス(たとえばHagging FaceやReplicate)も立ち上がってきた。おかげでこれまでよりモデルを共有したり統合しやすくなったばかりか、モデルプロバイダーと消費者をつなぐ間接的なネットワーク効果もある。また、エンタープライズ顧客に向けたファインチューニングやホスティング契約で収益化が可能になりそうでもある。

とはいえ、そうしたことのまだ先にモデルプロバイダーが抱えるのは次の課題だろう。

・コモディティ化:AIモデルの性能は、そのうちにいずれもそう変わらなくなると言われる。アプリケーション開発者と話していると、まだそうはなっていないことは明らかで、文章モデルでも画像モデルでもそれぞれに強いリーダー的企業が存在する。だがその強みは独自のアーキテクチャというよりも、莫大な資本やプロプライエタリなデータや希少なAI人材にある。はたしてこれからもずっと同じことが強みになるだろうか?

・卒業リスク:アプリケーション企業を立ち上げて事業を拡大する段階ではモデルプロバイダーの手を借りるのが一番だ。だが規模が一定拡大したところで、自分たちで独自のモデルを開発したりホストしたりするのは理にかなっている。モデルプロバイダーの多くは、少数のアプリケーション企業に売上の大半を頼っている。こうしたお得意様がAIモデルを社内開発に切り替えたらどうなるだろう?

・儲けにこだわるか:生成AIの可能性は果てしなく大きいがその反面、社会に害を与えかねない。そのため、多くのモデルプロバイダーは公益団体(たとえばBコープ)となり、利益の取り分に上限を定めているし、そうでない場合は企業ミッションの中に「世の中のためになる」という使命を明示している。それでも、難なく資金調達はできている。ただし、モデルプロバイダーが、必要とあれば本当に価値を取り込みたい、つまり儲けたいと思っているかどうかについては、議論の余地がありそうだ。

インフラ事業者はすべてに手を伸ばし、果実を刈り取る

ほぼすべての生成AIはどこかの時点でクラウドベースのGPU(またはTPU)を経由することになる。モデルプロバイダーや研究機関がワークロードの学習を行う場合も、ホスティング企業が推論/ファインチューニングを行う場合も、アプリケーション企業がその両方を行う場合もそうだ。生成AIを生かしているのはFLOPS(浮動小数点数演算の回数)である。コンピューティング分野の破壊的なテクノロジーが大規模処理能力によって推し進められるのは、ここしばらくの間なかった現象だ。

ということはつまり、生成AI市場に流れ込む「ものすごい額のカネ」はいずれにしろ最後にはインフラ企業に流れつくことになる。かなり当てずっぽうだが、どのくらいの金額になるかを書いてみよう。私たちの推測では、アプリケーション企業は売上の2割から4割程度を推論と各顧客向けのファインチューニングに使っている。計算処理に応じてクラウドプロバイダーに直接支払う場合もあれば、外部のモデルプロバイダーに支払う場合もある。すると、クラウドプロバイダーやモデルプロバイダーはその売上のおよそ半分をクラウドインフラに支払う。つまり、現在の生成AI市場の総売上の1割から2割がクラウドプロバイダーに行き着くと考えていいだろう。

その上に乗っかるのが、独自モデルを学習させるスタートアップがベンチャーキャピタルから調達した巨額の資金だ。この調達額の大半(アーリーラウンドの8割から9割近くまで)がクラウドプロバイダーに支払われている。上場テクノロジー企業の多くはモデル学習に毎年莫大な投資を行っているが、外部のクラウドプロバイダーを使うこともあれば直接ハードウェア製造企業と共同で行うこともある。

というわけで、「ものすごい額のカネ」というのはそういうことだ。とりわけ、黎明期の市場にとってはとんでもない金額になる。そのほとんどはビッグ3クラウドに行き着く。アマゾン・ウェブ・サービス(AWS)、グーグル・クラウド・プラットフォーム(GCP)、そしてマイクロソフト・アジュールだ。これらクラウドプロバイダーが、包括的で信頼できコスト効率の高いプラットフォームを維持するために行う設備投資額は、合計で年間1兆ドルにのぼる。生成AIの市場ではとりわけ、供給不足が既存巨大企業に有利に働く。彼らなら希少なハードウェア(NvidiaA100やH100GPU)を優先的に手に入れることができるからだ。

ただ面白いことに、それなりに強そうなライバルも出現している。多額の設備投資と販促費を負担できるオラクルのような挑戦者が参入してきた。スタートアップの中でもCoreweaveやLambda Labsは大手モデル開発企業に的を絞ったソリューションによって急速に成長している。彼らはコストが安く、手に入りやすく、個々へのサポートができるという点を打ち出している。また、大手のクラウドサービスがGPU仮想化の制限により仮想マシンのみを提供しているのに対し、こうしたスタートアップはより粒度が細かく抽象化されたリソース(たとえばコンテナ)を提供している。

舞台裏に目を移すと、生成AI領域で一番儲かっているのはワークロードの大部分を一手に引き受けている企業、Nvidiaである。2023年の第3四半期にはデータセンター向けGPU売上が38億ドルにのぼった。生成AIのユースケースのかなりの部分がここに含まれる。しかも、長年にわたってGPUのアーキテクチャに莫大な投資を行い、ソフトウェアの生態系を強化し、学術会での研究利用を幅広く促進してきたおかげで、群を抜いた優位性が築かれている。NvidiaのGPUは、ほかのAIチップを製造するトップのスタートアップすべてを合わせたよりも90倍も頻繁に学術論文に引用されているとも言われる。

もちろんほかにもハードウェアの選択肢がないわけではない。グーグルのTensor Processing Units(TPUs)、AMDのInstinct GPUs、AWSのInferentiaとTrainium チップなどだ。また、Cerebras、Sambanova、Graphcoreといったスタートアップが作るAIアクセラレーター群もある。インテルは後発だが、高価格のHabanaと Ponte Vecchio GPUsで市場に参入している。だがこうした新しいチップで大きな市場シェアを獲得できている企業はほとんどない。例外として注目すべきなのは2社。1社はグーグルで、そのTPUはStable Diffusionのコミュニティで引き合いがあり、大きなGCP案件もいくつか獲得している。もう1社はTSMCで、NvidiaのGPUも含めてここに挙げた半導体のすべてを製造している(インテルは自社製造工場と一部TSMCの工場を使っている)。

言い換えると、生成AI市場の中ではインフラストラクチャーの層(企業群)が儲かるし、持続性と優位性もあるということだ。インフラ企業の課題は以下の通りである。

・ステートレスなワークロードをつなぎ留めることができるか:NvidiaのGPUはどこで借りても性能は変わらない。AIワークロードのほとんどはステートレスである(状態変化を保持せず、一過性)。モデルによる推論作業はデータベースやストレージを伴わなくてもできる(モデルそのもののストレージは別として)。そのため既存のアプリケーションよりもAIのワークロードは持ち運びがしやすくクラウドを変えやすい。だとすると、クラウドプロバイダーはどのように顧客をつなぎ留め、最安値のプロバイダーへの流出を防いだらいいのだろう?

・半導体不足が解消されたら生き延びられるか:クラウドプロバイダーの価格設定も、またNvidia自身の価格設定も、人気GPUの供給不足に支えられている。A100のカタログ価格は発売当初より上がっていると言うプロバイダーもいるが、これはコンピューターハードウェアの世界では極めて珍しい現象だ。増産によって、また/あるいは新たなハードウェアプラットフォームの採用によって今の供給不足が解消されたら、クラウドプロバイダーはどんな影響を受けるだろう?

・挑戦者は壁を突破できるか:より専門性の高い特殊なプロダクトを提供する垂直統合型のクラウドならきっと市場シェアを獲得できるはずだと私たちは思っている。今のところ挑戦者たちはほどほどの技術的な差別化とNvidiaの支援によって、それなりのトラクションを獲得している。Nvidiaにとって既存クラウドプロバイダーは最大顧客であり、生まれつつある新たなライバルでもあるからだ。だがこれだけで、この先ビッグ3のスケールメリットに打ち勝つことができるのだろうか?

とすると、価値はどこに蓄積されるのだろう

もちろん、私たちにも答えはない。ただ、これまで見てきた初期のデータと、初期のAIおよび機械学習スタートアップからの私たちの経験を組み合わせると、次のような勘が働く。

今のところ、生成AI市場には構造的な優位性が存在しないように見える。パッと見た限り、アプリケーションには際立った差別化がないようだ。いずれも似たようなモデルを使っているからだ。モデルが学習するデータセットはほとんど同じだし、アーキテクチャもそれほど変わらない。クラウドプロバイダーも同じGPUを使っているので技術的に際立った差別化は見当たらない。ハードウェア企業でさえも、半導体の製造に使っているのは同じ工場だ。

もちろんこれら以外に通常の差別化要因がないわけではない。規模の優位性(「オレらは資金調達力がすごい!」とか)、サプライチェーンの優位性(「こっちはGPUが確保できるけど、そっちはできないだろ!」とか)、エコシステムの囲い込み(「みんなうちらのソフトウェアを使ってる!」とか)、アルゴリズムの優位性(「こちらの方が賢いんだ!」とか)、販売力(「セールスチームもあるし顧客もいる!」とか)、データパイプラインの優位性(「うちらの方がインターネットを地道に掘り起こしてるよ!」とか)などだ。だがこうした差別化要因のいずれも未来永劫続くものではない。また、いずれの層においても、直接的で強いネットワーク効果が働くかどうかは今の段階ではまだ判断できない。

今手元にあるデータを見ただけでは、生成AI市場で長期にわたって支配的な存在が生まれるかどうかはわからないのだ。

これは奇妙な状態だ。と同時に私たちにとってはそれがチャンスだ。この市場の潜在規模は計り知れない。すべてのソフトウェアを合わせた規模と、人類の努力をすべて集めた規模のあいだのどこかにそれがある。だから、この市場の各層で数多くのライバルが勃興し、健全な競争が繰り広げられるだろうと期待している。また、エンドユーザーとエンドマーケットの要求に最良な形で応えるような垂直型と水平型の企業が成功するだろうとも考えている。たとえば、エンドプロダクトの主な差別化ポイントがAIそのものであれば、垂直統合(自社開発モデルとがっつり結びついたユーザー向けアプリケーション)が有利に働くだろう。一方、AIが大型のロングテールの機能の一部であれば、水平統合が起きるはずだ。もちろん、そのうちに伝統的な差別化要因が築かれることは予想できる。一方で、新たな種類の差別化要因が生まれる可能性もある。

いずれにしろ、生成AIが競争のあり方を変えるのは確かだ。私たちの誰もが今この瞬間に走りながらそのルールを学んでいる。その過程で莫大な価値が生まれるだろう。そして、テクノロジー業界の景色はこれまでとまったく違うものになるはずだ。私たちはそれを待ち望んでいる。

*本ブログ記事の画像はすべてMidjourneyを使って生成した。

生成型AIプラットフォームの勝者とは

(執筆:Matt Bornstein, Guido Appenzeller, Martin Casado)

我々は既に、生成型AI市場における初期的な技術スタックが揃いつつあると考えている。市場には数百社にも及ぶスタートアップが参入し、基盤モデルの開発、生成型AIを組み込んだアプリの開発、開発にあたってのインフラやツールを提供している。

これまで注目を集めてきた技術革新の多くは、その本質を市場が理解する前に過度にもてはやされてきた。その一方で、生成型AIブームでは事業者が既に実践的な運用を行っており、市場で実績を積み上げている。Stable DiffusionやChatGPTといったモデルにおけるユーザー増加速度は目覚ましく、いくつかの生成型AIを活用したアプリでは実装から1年未満で年間収益が1億ドルに到達したものもある。人間と比較しても、特定の業務ではAIモデルが人間を超えたパフォーマンスを発揮している。

このように、生成型AIの活用による壮大な変革が現在進行形で進んでいることを示唆するデータは数多く存在する。この変革を理解する上で、私たちは生成型AI市場のどこに価値が集約し創造されているのか?という疑問を明らかにせねばならない。

昨年、我々は生成型AIを取り扱う大企業の幹部やスタートアップの創業者など数十名にインタビューを行った。その結果、生成型AIにおけるインフラ提供企業が市場で最も収益を上げている可能性が高いことが分かった。生成型AIの技術スタック市場に流れる資金の大部分はインフラ提供企業が獲得していると見られる。一方で、生成型AIアプリを開発する企業は売上高を急速に伸ばしているものの、既存顧客維持、製品差別化、粗利益率の向上に苦戦しているケースが多い。また、ほとんどの生成型AIの基幹モデルを提供する企業は、市場の根本に位置するサービスを提供しているにも関わらず、未だ大規模な商業化には至っていない。

言い換えれば、最も価値を創出している企業 (生成型AIモデルをトレーニングする企業や新しいアプリに導入している企業)は、そのほとんどを享受できていないのだ。この状況で生成型AI市場の次なる動きを予測するのは極めて困難である。しかし、我々が本質的に理解するべきなのは生成型AI市場において技術スタックのどのセクター部分が競合と差別化され、参入障壁を築けるかという点である。これが、市場構造(水平展開 or 垂直展開)や中長期的な価値の源泉(マージンとリテンション)などに大きな影響を与えると考えられる。

現状、生成型AIの技術スタック市場において既存企業が構築できる競合優位性は古典的なもの以外存在していない。

我々は、生成型AI市場の成長に強い期待感を抱いており、ソフトウェア産業だけでなく、それを超えた分野でも大きな影響を与えると信じている。この記事の目的は、市場の力学を明らかにし、生成型AIのビジネスモデルについての広範な疑問に答えを出すことである。

高次元の技術スタック:インフラ、モデル、アプリケーション

生成型AI市場がどのように形成されつつあるかを理解するためには、まず現在の技術スタックの構造を定義する必要がある。以下が我々の暫定的な見解である。

生成型AIの技術スタックは三つの層に分けられる:

- 生成型AIモデルを一般ユーザー向けに提供するアプリケーションのレイヤー

アプリには2種類が存在し、各社が自社のモデルパイプラインを動かす(一気通貫型のアプリ)か、第三者のAPIを活用するアプリに大別される。

- 生成型AI製品の出力に必須なモデル(大規模言語モデルなど)のレイヤー

このモデルを活用する際はモデルから提供される独自APIを取得するか、またはオープンソースのチェックポイントとして(ホスティングサービスを必要とする)提供されるものを活用する。

- 生成型AIモデルの訓練と推論を実行するインフラストラクチャのレイヤー

すなわち、クラウドプラットフォームとハードウェアメーカーなどのインフラを提供するベンダーである。

留意するべきポイント:前述したレイヤーは市場の概観ではなく、市場を分析するためのフレームワークに過ぎない。上図では各カテゴリーにおける、代表的なベンダーの例をいくつか挙げている。

現状我々は、生成型AIを活用したスタートアップ企業をリストアップする作業を行っていない。また、まだ高度に標準化されていないMLopsやLLMopsのツールについては、今回の記事では詳しく触れていないが、今後の記事で詳しく取り上げる予定である。

生成型AIアプリケーションの第一波は急速な経済的成長を実現し始めているが、持続的な顧客維持と差別化に課題を抱えている。

以前の技術サイクルにおいて、企業の大きな成長と自立を実現させるためには、独自にエンドユーザー(個々の消費者やB2Bのバイヤーを含む)を獲得する必要があるというのが一般的な考え方であった。そのため、生成型AI市場においても大手企業が提供するサービスはエンドユーザ向けアプリケーションである可能性が高いと考えてしまうだろう。しかし、本市場も従来と同様にエンドユーザーを獲得するセオリーが効果的な打ち手かは明確に示唆が出ていない。

確かに、生成型AIアプリケーションの成長は驚異的であり、その新規性と多様な利用用途によって市場は急速に拡大している。実際、生成型AIアプリケーション市場の中でも、画像生成、コピーライティング、コード生成の3セクターでは年間の売上高が1億ドルを超えている。

しかし、急速な成長だけでは持続性のあるソフトウェア企業を築くのに不十分である。売上の成長に伴って、収益性も向上させなければならない。つまり、ユーザーや顧客を定着させ、恒常的に高水準の利益を生み出すシステムを設計することが必要なのだ。技術的側面において強力な競合優位性がない場合は、B2BとB2Cのアプリケーションでは、ネットワーク効果、データ保持、複雑なワークフローなどを活用することで長期的な顧客価値を生み出す必要が発生する。

生成型AIにおいては、これらの前提条件が必ずしも当てはまるわけではない。我々がインタビューをしたアプリ企業全体で見ると、粗利益率の幅は広く、一部のケースでは90%にも達するが、多くの場合は推論モデルの保守コストによって50-60%の水準まで低下している。トップオブファネルの成長は驚くべきものだが、現行の顧客獲得戦略の拡張性には疑問が残る。一部ではすでに有料会員獲得の効果や顧客維持率が減少し始めているケースも存在しており、多くのアプリケーション開発企業が類似基盤AIモデルに依存しているため、明確な競合優位性となりうるネットワーク効果やデータ/ワークフローを見つけられていない。そのため、差別化が困難な市場環境となっている。

したがって、エンドユーザー向けのアプリケーションを開発することが、持続可能な生成型AIのビジネスモデルを築く唯一の、あるいは最良の方法であるとは明確に示されていない。言語モデルの競争と効率性が向上するにつれて仲介コストは改善されるはずであり、一時的にAIを活用するライト層が離脱すれば顧客継続率も向上するはずである。

また、業界特化型のアプリケーションを開発することで盤石な競合優位性を作り出そうとする意見が存在しているが、これに関しても今後検証するべき事象は多く存在する。

今後、生成型AIアプリ企業が直面する大きな問題はいくつか存在する。

- 垂直統合(「モデル+アプリ」):AIモデルをサービスとして利用することで、アプリ開発者は少数のチームで迅速に反復を重ね、技術の進歩に合わせて活用する生成型AIのモデルを別のものに切り替えることができる。その反面、AIモデルそのものが製品であると主張する開発者もいる。独自の製品データで継続的にモデルの学習を行うなどの行為が、競合優位性を生む唯一の方法だという主張をしているのだ。ただし、このためには莫大な資本が必要であり、開発チームの機動性が損なわれる可能性が高い。

- 機能対アプリ:生成型AI製品はデスクトップアプリ、モバイルアプリ、Figma/Photoshopのプラグイン、Chromeの拡張機能、さらにはDiscordのボットまで多岐に及ぶ。基本的にはUIのほとんどがテキストボックスであるため、ユーザーがすでに使っているサービスに生成型AI機能を統合することは容易である。これらのサービスプロバイダのうち、どれが独立した企業になり、どれが基盤のサービスを提供する企業、例えばマイクロソフトやGoogleに吸収されるのだろうか?

- ハイプサイクルの管理:現行の生成型AIの製品において相次ぐ既存顧客の離脱が固有の現象なのか、それとも新興市場特有の傾向なのかはまだ明らかでない。また、ハイプサイクルの中で生成型AIが沈静化していくと、顧客の関心も同時に損なわれるか否かという点も予測できない。これらの懸念点は、生成型AIを活用したアプリを開発する企業にとっては重要な意味を持ち、資金調達のタイミング、顧客獲得への投資にどれほど資本を投入するべきか、重点を置くべきユーザーセグメント、サービスのローンチをするタイミングなどに影響を与える。

モデルプロバイダは生成型AIを発明したが、まだ大きな商業規模には達していない。

今日、私たちが生成型AIと呼んでいるものは、Google、OpenAI、Stabilityなどの企業が行ってきた優れた研究とエンジニアリングがなければ存在しないであろう。斬新なモデル・設計と学習パイプラインを拡張するための膨大な努力によって現在の大規模言語モデル(LLMs)および画像生成モデルの驚くべき能力は担保され、皆がそれを享受している。

しかしこれらの企業が得る生成型AIに関する収益は、モデルの使用量や話題性に比べて未だ相対的に小さい。画像生成においては、Stable DiffusionがUIのエコシステム、ホスティングサービス、高精度のファインチューニングに支えられて、爆発的なコミュニティの成長を実現している。しかし、事業のマネタイズにおける核である主要なチェックポイントをテネットとして無料で提供している。自然言語モデルにおいては、OpenAIがGPT-3/3.5とChatGPTで莫大なシェアを保有している。しかし、これまでにOpenAIに基づいて作られたキラーアプリの数は比較的少なく、モデル利用の価格はすでに一度下がっている。

確かにこれは一時的な現象の可能性がある。Stabilityは新興企業であり、未だ収益化に焦点を当てていない。OpenAIは今後、多くのキラーアプリが作成されるにつれてNLP部門の収益が大幅に増加し、大規模なビジネスになる可能性がある。特に、Microsoftの製品ポートフォリオへの統合が順調に行けばより成長は加速する。これらの企業が開発したAIモデルの膨大な使用量を考慮すると、大規模な収益化は遠くないかもしれない。

しかし、この成長に向けて大きなハードルも存在する。オープンソースとして公開されたモデルは、誰でもホスティングできる設計である。そのため、社外の組織であっても大規模なモデルトレーニングに伴うコスト(数千万から数億ドルにも及ぶ)を負担しないで活用することができる。

また、クローズドソースのモデルの場合もその優位性を維持しきれない可能性がある。例えば、Anthropic、Cohere、Character.aiといった企業が作成した大規模言語モデルは、Open AI社と同様のデータセットと同じようなモデル構造で自社の生成型AIのトレーニング・学習をしている。この取り組みによって、前述した企業の製品はOpenAIが開発する生成型AIと同等のパフォーマンスに近づきつつある。また、Stable Diffusionのケースでは、オープンソースのモデルが十分なレベルの能力とコミュニティサポートを獲得した場合、プロプライエタリな製品が競争に勝利するのが難しくなる可能性があると示唆されている。

おそらく、これまでの歩みの中でモデルプロバイダーが得た最も明確な示唆は、商業化がホスティングに大きく関連しているということだろう。独自のAPI(例えば、OpenAIから)に対する需要は急速に増加している。加えて、オープンソースのモデル用のホスティングサービス(例えば、Hugging FaceやReplicate)は、モデルを簡単に共有し統合する便利なハブとして台頭し始めており、モデルの提供者と消費者の間に間接的なネットワーク効果ももたらすこともある。さらに、企業顧客とのファインチューニングとホスティング契約を通じて収益化することが可能である可能性が高いという仮説も存在している。

しかしそれ以上に、AIモデルの提供を行う企業が直面するいくつかの大きな問題がある:

- コモディティ化: AIモデルのパフォーマンスは時間とともに収束するという一般的な通説がある。アプリ開発者によるとテキストと画像の生成モデル、この双方で市場に強大なプレイヤーが存在しているため、現状は通説のようにモデルの性能が収束する自体には陥っていない。この強大なプレイヤーが持つ優位性は、ユニークなモデル設計に基づいているのではなく、高い資本力、独自に保有するデータ、および希少な生成型AIのエンジニア人材によって担保されている。これは持続可能な競合優位性となるだろうか?

- 独立リスク: 生成型AIのアプリ企業が事業をスタートする上で、モデルプロバイダに依存することは、成長する上で有用である。しかし、アプリケーションの規模を拡大すると、自社でモデルを構築および/またはホスティングするインセンティブが大きくなってくる。また、多くのモデルプロバイダは、少数のキラーアプリ事業者が収益の大半を支えている。これらの顧客が社内で生成型のAI開発に切り替えるという意思決定を行った場合、モデル提供企業の収益はどうなるのだろうか?

経済的な合理性は重要か?: 生成型AIの将来性は非常に大きく、かつ潜在的には非常に有害であるため、多くのモデルプロバイダは公益法人(Bコープ)として組織化し、上限付きの利益分配を行っている。もしくは、企業のミッションにおいて明示的に公共の利益を組み込んでいるケースが多い。これらの方針が企業としての資金調達に支障をきたすことはない。しかし、モデルプロバイダが実際にこの価値を獲得したいと考えているのか、またそれをするべきなのかという論点は妥当な議論を重ねてゆく必要がある。

インフラストラクチャのベンダーは生成型AIのレイヤーすべてに関与し、収益を獲得する

生成型AIのほぼすべては、どこかのポイントでクラウドホスティングされたGPU(またはTPU)を経由する。モデルプロバイダや研究機関がトレーニングワークロードを実行する場合、ホスティング企業が推論やファインチューニングを行う場合、またはアプリケーション開発を行う企業がその両方の組み合わせを行う場合など、FLOPSは生成型AIの心臓である。

その結果、生成型AI市場に存在する多くの資金は最終的にインフラストラクチャ企業に流れている。非常にざっくりとした数字で言えば、平均して、アプリケーションを開発する企業の収益の約20〜40%を推論と顧客ごとに調整するファインチューニングに費やしていると推定される。これらのコストは基本的に、コンピューティング・インスタンスのために直接クラウドプロバイダに支払われるか、または第三者のモデルプロバイダに支払われる。つまり、今日の生成型AI市場の総売上高における10〜20%はクラウドプロバイダーに支払われていると推測するのが妥当だろう。

加えて、独自の生成型AIモデルをトレーニングするスタートアップは、数十億ドルをベンチャーキャピタルから調達しており、その大部分(初期ラウンドでは最大80〜90%)をクラウドプロバイダーに対して支出する。多くの上場したテクノロジー企業では、外部のクラウドプロバイダーまたはハードウェアメーカーに年間数億ドルを支出している。

専門用語で言えば、これは「大金」である。その資金のほとんどはBig 3のクラウドで支出されている:Amazon Web Services(AWS)、Google Cloud Platform(GCP)、Microsoft Azure。これらのクラウドプロバイダーは、最も包括的で信頼性があり、コスト競争力のあるプラットフォームを確保するために、年間で合計で1000億ドル以上の事業投資をしている。特に生成型AIでは、希少なハードウェア(Nvidia A100やH100 GPUなど)に優先的にアクセスできるため、供給制約の恩恵も受けている。

しかし、興味深いことに、これらの事業者に対して明確な競合が出現し始めている。Oracleをはじめとする挑戦者は、大規模な資本支出と販売インセンティブによって独占的なクラウド提供事業においてポジショニングを確立し始めている。CoreweaveやLambda Labsのようないくつかのスタートアップは、特に大規模なモデル開発者を対象としたソリューションを軸に急速な成長を実現している。これらの企業はコスト、可用性、パーソナライズされたサポートなどの競合優位性を保有している。また、大規模クラウドがGPUの仮想化制限によってVMマシンインスタンスしか提供できないのに対し、これらのスタートアップはより詳細なリソースの抽象化を提供している。

舞台裏で、AIワークロードの大半を動かしているのは、これまで生成型AI市場で最も成功している可能性がある企業、Nvidiaである。同社は、2023年度第3四半期にデータセンターGPUの売上が38億ドルに到達し、その中には生成型AIのユースケースがその大半を占めていると報告している。また、NvidiaはGPU設計、堅牢なソフトウェアエコシステム、学術コミュニティの深い利用といった、何十年にもわたる投資によって強固な競合優位性を築くことに成功している。最近の分析では、NvidiaのGPUは研究論文でAIチップ製造スタートアップ全体よりも90倍多く引用されていることが明らかになっている。

Nvidia以外にもハードウェアの選択肢は存在する。GoogleのTensor Processing Units(TPU)、AMDのInstinct GPU、AWSのInferentiaとTrainiumチップ、CerebrasやSambanova、Graphcoreといったスタートアップなどである。後発参入のIntelも、高級なHabanaチップとPonte Vecchio GPUで市場に参入している。しかし、これらの新しいチップが市場において大きなシェアの獲得に成功した事例は存在しない。例外として注目すべきは、GoogleのTPUがStable Diffusionコミュニティや一部の大規模なGCPの取引で人気を集めていること、TSMCがここに挙げたすべてのチップ、NvidiaのGPUも含めて製造しているとされていることである(Intelは自社のファブとTSMCを組み合わせてチップを製造している)。

つまり、インフラストラクチャを提供する事業者には中長期的な事業投資に裏付けされた強大で持続可能な競合優位性が存在する。しかし、これらの企業においても懸念点が存在している。

- ステートレスなワークロードの維持:NvidiaのGPUは、いついかなる場所で借りても出力が一定である。ほとんどのAIワークロードはステートレスであり、推論モデルにはモデルの重み自体以外を除いてデータベースやストレージを必要としない。これは、AIワークロードが従来のアプリケーションワークロードよりもクラウド間での移植性がより高い可能性があることを意味する。このような状況において、クラウドプロバイダーはどのようにして顧客のチャーンレートを低水準に維持し、価格競争になるのを防ぐのかという点は大きな懸念になりうる。

- チップ不足が解消される場合の競争:クラウドプロバイダー、そしてNvidia自体の価格設定は、高品質なGPUの供給が不足しているという市場の状況によって支えられている。あるプロバイダーは、A100の定価価格が実際にローンチ以降上昇していると語っており、これはコンピュートハードウェア市場においては非常に珍しい状況である。この供給の制約が最終的に解消された場合、新しいハードウェアプラットフォームの生産や採用が拡大した場合、それがどのようにクラウドプロバイダーに影響するのか?という点は予測が難しい点である。

- 後発プレイヤーのクラウドは先行プレーヤーの牙城を突破できるか:我々はBig 3と比較して、より専門的な需要に着目したクラウドサービスの提供で市場シェアを奪う業界特化型クラウド提供企業が現れると考えている。生成型AIの市場において現状、新規参入プレイヤーは適度な技術力の差別化と顧客であり、競合であるNvidiaの手助けによって成長を続けてきている。しかし、中長期的には規模の優位性を持つBig3に対してどのように対抗してゆくのかという大きな課題が残っている。

生成型AI市場の価値はどこに蓄積されるのか?

もちろん、現時点では分からない。ただ、既存のAI/ML企業で得た知見と、生成型AIに関する初期段階のデータを基にして、我々は以下のように推察する。

現在、生成型AIには体系的な優位性(moats)は観測できていない。アプリケーションレイヤーでは類似の生成型AIモデルを使用しているため、製品の差別化が困難になっている。モデルレイヤーでも、同様のデータセットとシステム設計でトレーニングされるため、長期的には出力の差別化が難しくなってくる。クラウドプロバイダでは、同じGPUを走らせているため、根本的な技術における出力の差別化は大きな課題となる。ハードウェア企業に至っても、チップを同じ製造所で作っているため差別化の問題は常に付きまとう。

もちろん、一般的な競合優位性も存在する:規模の優位性(「私はお前より多くの資金を調達できる!」)、サプライチェーンの優位性(「私がGPUを持っている、お前は持っていない!」)、エコシステムの優位性(「すでにみんなが私のソフトウェアを使用している!」)、アルゴリズムの優位性(「私たちはお前より賢い!」)、流通の優位性(「私にはすでに営業チームと多くの顧客がいる!」)、データパイプラインの優位性(「私はインターネットをより広範囲にクロールしている!」)。

しかし、これらの競合優位性が長期的に持続するかどうかは不明である。そして、どのレイヤーで強力かつ直接的なネットワーク効果が生じているのかも、市場が黎明期である現在は推測のしようがない。

入手可能なデータに基づくと、生成型AIの市場において中長期的に寡占体制を取り、利潤を総取りする企業が出てくるかは不透明である。

これは奇妙な状況だが、私たちにとっては朗報である。生成型AI市場の潜在的な規模は計り知れない。したがって多くのプレイヤーがこの市場の各レイヤーに参入し健全な競争が行われることが予測できる。また、水平型企業と垂直型企業の双方が成功することを期待しており、エンドマーケットとエンドユーザーにとって最適な提供の形が定義されると考えられる。例えば、製品の市場における主な差別化要因が生成型AIそのものであれば、垂直化している企業(ユーザー向けアプリと自社で独自開発するモデルの緊密な結合)が競争を制する可能性が高い。一方で、AIがより大規模な製品の一部として組み込まれた場合、水平的な展開をしている企業が勝つ場合もある。もちろん、より伝統的な競合優位性の構築も時間の経過に合わせて市場に起こる可能性があり、新しい競合優位性の形が定義される可能性もある。

いずれにせよ、確実なことは、生成型AIが市場環境と競争の形を変えるということである。私たちは同時にリアルタイムでルールを学び、このムーブメントによって解き放たれるであろう新たな価値は極めて大きい。今後、テクノロジーの常識や伝統は大きく変わるであろう。そして、私たちはそのためにここにいるのだろう。